Studentische Arbeiten

Die folgende Aufstellung gibt einen Überblick über Angebotene und Abgeschlossene Bachelor-, Master-, Studien- und Diplomarbeiten im Welfenlab.

Sollten Sie sich für eines der ausgeschriebenen Themen interessieren, oder haben Sie Interesse an einem ähnlichen Thema, so nehmen Sie bitte Kontakt mit Maximilian Klein auf.

Anzeigen:

- Alle Arbeiten

- Bachelorarbeiten

- Masterarbeiten

- Diplomarbeiten

- Studienarbeiten

- Seminararbeiten

Angebote

In Bearbeitung

|

Master thesis

Nils Hein

Differentialgeometrische Analyse von Power Flow und Power Grid Berechnungen

Beschreibungstext anzeigen

Im Kontext elektrischer Energietechnik befasst sich die Power Flow- bzw. die Power-Grid-Analyse mit der Energieversorung in komplexen Netzwerken. Übliche Herangehensweisen sind häufig algebraischer Natur und skalieren deswegen schlecht. Insbesondere in hochdimensionalen Parameterräumen sind die Berechnungen sehr aufwändig und numerisch problematisch. Ziel dieser Arbeit ist die Untersuchung differentialgeometrischer Verfahren im Hinblick auf verschiedene Beispiele aus dem Power-Flow Bereich. Dabei soll insbesondere untersucht werden, wie kompetitiv der differentialgeometrische Ansatz ist und was die Grenzen dieser Herangehensweise sind. Betreuer: Maximilian Klein April 2017

|

|

Master thesis

Pascal Urban

Automatisches Erzeugen von parallelen Programmen

Beschreibungstext anzeigen

Das Schreiben von parallelem Code ist meist ein aufwändiges und fehlerträchtiges Vorhaben. Moderne Programmiersprachen arbeiten oft imperativ und sind objektorientiert. Beides sind Paradigmen, die das Parallelisieren erschweren. Einerseits weil der Kontrollfluss nicht explizit gegeben ist. Andererseits, weil die Daten, die verarbeitet werden nicht explizit modelliert werden, sondern durch Paradigmen wie "Hidden State" abstrahiert werden. Es existieren andere Ansätze, wie z.B. die von der Programmiersprache Go verwendeten Channels, die aus Hoares CSP (Communicating Sequential Processes) hervorgingen. Prozessalgebren wie CSP oder CCS starten direkt mit der Annahme von parallel arbeitenden Prozessen und modellieren den Datenfluss (aus dem eine Art Kontrollfluss direkt ableitbar ist). Das am Institut entwickelte System "Buggy" arbeitet intern gerade mit der Semantik von CSP und garantiert damit eine transparente Situation in der das Erzeugen parallelen Codes zunächst eine einfache Folgerung aus den Regeln von CSP sind. Dies führt dazu, dass jede Operation sinnvoll parallelisiert werden kann. Das parallelisieren jeder einzelnen Operation würde jedoch zu einem zu großen Overhead führen. Ziel dieser Masterarbeit ist es, das Generieren von parallelen C-Code zu ermöglichen, mit dem Ziel die Programme möglichst effizient zu machen. Dabei sollen verschiedene Heuristiken erarbeitet werden, die entscheiden, wann welche Parallelisierungsvarianten (wie z.B. Pipelining) angewandt werden. Betreuer: Maximilian Klein Januar 2017

|

Abgeschlossen

| 2017 | |||

|

Master thesis

Jan Jamaszyk

Leibniz Universität Hannover

Implementierung eines Self-Sensing-Konzepts in die Ansteuerung eines Taktilen Displays

Beschreibungstext anzeigen

Im Rahmen eines DFG-Projektes entwickeln das Welfenlab, das IDS und das IMPT ein taktiles Display, das das Ertasten von unterschiedlichen virtuellen Oberflächenstrukturen wie Textilien, Leder, Holz und Kunststoffen ermöglichen soll. Für die taktile Wahrnehmung ist eine Vielzahl von unterschiedlichen, sich im Finger befindlichen Mechanorezeptoren zuständig. Jeder Rezeptortyp reagiert auf bestimmte Reize und Anregungsfrequenzen besonders sensibel. Um taktile Oberflächeneindrücke möglichst exakt nachbilden zu können, muss eine gezielte Anregung dieser unterschiedlichen Rezeptoren erfolgen. Dazu bedarf es neben der mechanischen Aktorik auch eines geeigneten Ansteuerungsmodells und einer gezielten Steuerung. Die Modellierung einer konsistenten Ansteuerung hängt unter anderem auch von dem Systemverhalten des Displays sowie der mechanischen Impedanz der Fingerkuppe ab und ist im Allgemeinen nicht a priori bekannt. Insbesondere individuelle Unterschiede im Gewebeverhalten des Fingers und der variable Anpressdruck auf das Display können im bereits bestehenden System zurzeit nicht erfasst werden und erschweren damit die Vergleichbarkeit der Eindrücke zwischen verschiedenen Benutzern. Ziel dieser Arbeit ist der Entwurf und die Implementierung einer Erweiterung des bestehenden Systems, die es erlaubt während der Benutzung des Displays Impedanzmessungen durchzuführen und durch regelungstechnische Maßnahmen individuelle Unterschiede zwischen den Anwendern auszugleichen. Als Grundlage für diese Messungen soll das Prinzip des "Self-Sensings" genutzt werden, welches es erlaubt aus Strom- und Spannungsvariationen an einem piezoelektrischen Biegeaktor Rückschlüsse auf die anliegenden Kräfte und Geschwindigkeit zu ziehen. Teil dieser Arbeit ist der Entwurf einer Verstärkerschaltung, welche den Anforderungen an die Betriebsspannung des eingesetzten Biegeaktors genügt, sowie der Entwurf und die softwareseitige Implementierung einer aktiven Kompensation über einen Mikrocontroller. Im Rahmen dieser Arbeit ergeben sich insbesondere die folgenden Aufgabenpunkte:

Betreuer: Andreas Tarnowsky Januar 2016

Juli 2017

|

|||

|

Master thesis

Nicola Gruhl

Grundlangen zur differentialgeometrischen Analyse von Power Flow und Power Grid Berechnungen

Beschreibungstext anzeigen

Im Kontext elektrischer Energietechnik befasst sich die Power Flow- bzw. die Power-Grid-Analyse mit der Energieversorung in komplexen Netzwerken. Übliche Herangehensweisen sind häufig algebraischer Natur und skalieren deswegen schlecht. Insbesondere in hochdimensionalen Parameterräumen sind die Berechnungen sehr aufwändig und numerisch problematisch. Ziel dieser Arbeit soll eine grundlegende differentialgeometrische Untersuchung des Problems sein. DIe hierraus resultierenden numerischen Methoden haben in natürlicher Weise bessere Skalierungseigenschaften und sind daher numerisch stabiler und effizienter. Betreuer: Maximilian Klein November 2016

Mai 2017

|

|||

| 2016 | |||

|

Master thesis

Falk-David Deppe

Institut für Mensch-Maschine-Kommunikation

Erkennung und Rekonstruktion von 3D Objekten aus RGBD-Daten

Beschreibungstext anzeigen

Durch die gestiegene Verfügbarkeit erschwinglicher RGBD-Sensoren hat das Gebiet der Virtual Reality in den letzten Jahren einen großen Aufschwung erlebt, da diese es erlauben, auch ohne spezialisierter Messgeräte virtuelle 3D-Modelle realer Szenen und Objekte zu erzeugen.

Betreuer: Andreas Tarnowsky April 2016

Oktober 2016

|

|||

| 2015 | |||

|

Master thesis

Daniel Busse

Leibniz Universität Hannover

Entwicklung eines stochastischen Modells für die 3D-Segmentierung medizinischer Tomographiedaten

Beschreibungstext anzeigen

Die Medizin hat im letzten Jahrhundert in Form von bildgebenden Verfahren ein bedeutendes Hilfsmittel erhalten. Basierend auf verschiedenen physikalischen Eigenschaften, bilden sie die innere Anatomie eines Patienten auf diskrete Volumendaten ab: Es entstehen dreidimensionale Bilder, auf denen unterschiedliche Gewebearten durch variierende Grauwerte dargestellt werden. Betreuer: Karl-Ingo Friese Januar 2015

Juli 2015

|

|||

| 2013 | |||

|

Master thesis

Friedrich Hattendorf

Implementation und Analyse von Triangle Strip Algorithmen

Beschreibungstext anzeigen

Volumenkörper werden in der Computergrafik oft durch die Darstellung ihrer Oberfläche als Dreiecksnetz repräsentiert. Gerade bei komplexeren Objekten kann dabei die Dreieckszahl schnell mehrere Millionen erreichen, was auch heute noch eine Herausforderung für die Grafikkarte darstellt. Zwar existieren Verfahren, die ein Dreiecksnetz vereinfachen (= die Anzahl der Dreiekce reduzieren), dabei besteht jedoch immer die Gefahr, dass wichtige Details der Oberfläche Verloren gehen können oder schlimmstenfalls sogar Selbstüberschneidungen erzeugt werden. Eine interessante Alternative stellen die sogenannten Triangle-Strips dar. Bei dieser Datenstruktur, wird versucht, das Netz aus möglichst langen Dreiecks-Streifen zusammenzusetzen, bei der sich jeweilst zwei aufeinanderfolgende Dreiecke genau eine Kante teilen. Durch diesen Trick lässt sich im Idealfall der benöitgte Speicheraufwand auf 1/3 reduzieren. Das Problem der Findung einer solchen idealen Zerlegung ist jedoch N(P) vollständig. Daher existieren eine Vielzahl von Verfahren, die mit heuristischen Methoden versuchen, eine möglichst gute Triangle Strip Darstellung zu finden. Ziel dieser Arbeit ist es, verschiedene Verfahren aus dieser Kateogrie zu implementieren und für Dreiecksflächen aus medizinischen Anwendungen zu vergleichen. Zusätzlich soll ein eigenes Verfahren implentiert werden, bei dem der Augenmerk nicht in einer möglichst guten Strip Darstellung sondern der Erzeugung der Strip Struktur ohne nennenswerten Zeit- und Speicheraufwand liegt. Betreuer: Karl-Ingo Friese November 2012

Mai 2013

|

|||

| 2012 | |||

|

Master thesis

Marco Köhnen

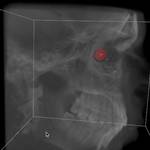

Entwicklung einer halbautomatischen Segmentierungsmethode zur Bestimmung der intrakraniellen Luftmenge nach einer Schädeloperation

Beschreibungstext anzeigen

In dieser Arbeit soll ein neuer Ansatz automatischer Verfahren mit Hilfe von Deformable Models und gängiger Segmentierungsverfahren verfolgt werden, um den Liquorverlust nach einer Schädel-Operation zu Bestimmen.

Beschreibungstext verbergen

Hintergrund sind Operationen, bei denen der Patient in einer halb-sitzenden Stellung am Hinterkopf operiert wird. Eine Folge davon ist ein Verlust an Flüssigkeit, die sich im Laufe der Zeit rückbildet. Um diesen Rückbildungsprozess untersuchen zu können, soll ein halb-automatisches Verfahren zur Bestimmung der intrakraniellen Luftmenge etnwickelt und mittels umfangreicher bereits vorliegender Daten auf Reproduzierbarkeit und Güte getestet werden.

Hintergrund sind Operationen, bei denen der Patient in einer halb-sitzenden Stellung am Hinterkopf operiert wird. Eine Folge davon ist ein Verlust an Flüssigkeit, die sich im Laufe der Zeit rückbildet. Um diesen Rückbildungsprozess untersuchen zu können, soll ein halb-automatisches Verfahren zur Bestimmung der intrakraniellen Luftmenge etnwickelt und mittels umfangreicher bereits vorliegender Daten auf Reproduzierbarkeit und Güte getestet werden.

Betreuer: Karl-Ingo Friese Juni 2012

Dezember 2012

|

|||

| 2011 | |||

|

Master thesis

Maximilian Hans Gerhard Klein

Local Refinement Methods for Fluid Simulation

Beschreibungstext anzeigen

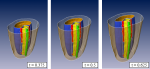

Die Komplexität der Simulation dynamischer Prozesse in Echtzeit setzt enge Grenzen was die Problemgröße und die Genauigkeit von SImulationen selbst auf neuester Hardware angeht. Dabei ist es häufig gar nicht nötig, jede Lösung über einem Teilgebiet der Simulationsdomäne mit der selben Präzision zu berechnen. Häufig liefern adaptive Verfahren bei einer Verringerung der Freiheitsgrade bessere Ergebnisse. Diese Arbeit untersucht im Kontext der Fluidsimulation eine adaptive Fassung des Multigrid Algorithmus, der diese Eigenschaft nutzen soll um interaktive Fluidsimulation mit hoher Genauigkeit zu ermöglichen.

Dazu wird in einem sog. splitting Verfahren die Lösung der Fluidgleichungen in zwei Teilschritte zerlegt. Im ersten Schritt wird mit einem sog. semi-lagrangian Verfahren das (vorläufig divergenzbehaftete) Geschwindigkeitsfeld nach Einwirkung von verteilten Kräften, Randbedingungen und Advektion berechnet. Dieses wird dann in einem zweiten Schritt durch die Lösung eines geeigneten Poissonproblems mittels der Multigridmethode auf seinen divergenzfreien Anteil projiziert.

Beschreibungstext verbergen

Betreuer: Rasmus Buchmann April 2011

Oktober 2011

|

|||

|

Master thesis

Matthias Becker

Welfenlab + Kiefer-, Mund und Geschitschirurgie der MHH

Modellbasierte Orbita Segmentierung und die automatisierte Bestimmung anatomisch relevanter Parameter

Beschreibungstext anzeigen

Der Begriff Segmentierung beschreibt die Auswahl von Voxeln in einem Volumendatensatz entsprechend einem vom Benutzer gewählten Homogenitätskriterium. Ein einfaches Verfahren könnte z.B. alle Voxel zwischen einer unteren oder oberen Intensitätsschranke segmententieren (Min-Max-Verfahren). Sollen komplexere Formen erkannt werden, kommen meist modellbasierte Verfahren zum Einsatz. Ein Beispiel für eine solche, komplexe Form, stellt die knöcherne Augenhöhle (Orbita) dar. Ziel dieser Masterarbeit war es, modellbasierte Verfahren anhand des klinisch relevanten Beispiels der Orbita-Segmentierung zu untersuchen. Die entwickelten Algorithmen sind jedoch allgemeiner und auch für andere Anwendungsfälle einsetzbar. Ein Hauptaugenmerk lag dabei auf dem Deformable Model Ansatz. Dabei wird ein zur gesuchten Segmentkontur topologisch äquivalentes Startmodell schrittweise "aufgeblasen" und durch geeignete innere oder äußere Parameter (Formerhaltung, Gradienten, ...) gebremst. Zur Demonstration des Verfahrens wurde ein Modul für die von Karl-Ingo Friese geschriebene Software YaDiV entwickelt werden, das die Visualisierung und Kontrolle der Evolutionssparameter in jedem Schritt erlaubt. In der Ausarbeitung wurde der Einfluss unterschiedlicher Parametergewichtungen untersucht. Ein weiteres Ziel dieser Arbeit bestand in der automatisierten Bestimmung anatomisch interessanter Punkte und Größen (Winkel, Abstände, etc.) und einer Analyse der Segmentgüte. Betreuer: Karl-Ingo Friese Oktober 2010

April 2011

|

|||

| 2010 | |||

|

Master thesis

Benjamin Berger

Leibniz Universität Hannover

Untersuchung von Eigenwertspektren zur Klassifikation von Bildinformation

Beschreibungstext anzeigen

Es gibt viele Gründe Verfahren zu entwickeln, die zu gegebenen Daten Duplikate oder "ähnliche" Versionen finden können. Die Anwendungen reichen von der Organisation von Datensammlungen über Mustererkennung bis zum Urheberrechtsschutz.

In dieser Arbeit soll ein solches Verfahren für Bilddaten vorgestellt werden. Bei den bisherigen Verfahren, sofern sie ähnlich wie das in dieser Arbeit beschriebene die Bilder in Eigenwertprobleme umwandeln und dann die Eigenwertspektren vergleichen, wurde kein Augenmerk darauf gerichtet, inwieweit sich Information über Bildteile, also von Kanten umgrenzte Gebiete einigermaßen gleichförmiger Helligkeit, im Eigenwertspektrum unterbringen lässt beziehungsweise in einer für den Ahnlichkeitsvergleich sinnvolllen Weise berücksichtigen lässt. Diese Arbeit ist ein erster Versuch, die Problemstellung des partiellen Matching mit derartigen eigenwertbasierten Methoden anzugehen. Es gibt viele Gründe Verfahren zu entwickeln, die zu gegebenen Daten Duplikate oder "ähnliche" Versionen finden können. Die Anwendungen reichen von der Organisation von Datensammlungen über Mustererkennung bis zum Urheberrechtsschutz.

In dieser Arbeit soll ein solches Verfahren für Bilddaten vorgestellt werden. Bei den bisherigen Verfahren, sofern sie ähnlich wie das in dieser Arbeit beschriebene die Bilder in Eigenwertprobleme umwandeln und dann die Eigenwertspektren vergleichen, wurde kein Augenmerk darauf gerichtet, inwieweit sich Information über Bildteile, also von Kanten umgrenzte Gebiete einigermaßen gleichförmiger Helligkeit, im Eigenwertspektrum unterbringen lässt beziehungsweise in einer für den Ahnlichkeitsvergleich sinnvolllen Weise berücksichtigen lässt. Diese Arbeit ist ein erster Versuch, die Problemstellung des partiellen Matching mit derartigen eigenwertbasierten Methoden anzugehen.Betreuer: Alexander Vais Juni 2010

Dezember 2010

|

|||

| 2009 | |||

|

Master thesis

Marc Christoph Vollmer

Leibniz Universität Hannover

Entwurf und Implementation einer haptischen Schnittstelle für YaDiV

Beschreibungstext anzeigen

In der heutigen Zeit wird aufgrund neuer technischer Innovationen und verstärkter Rechenleistung das Immersionsgefühl des Benutzer immer weiter gesteigert. Das Teilgebiet zur Integration von Haptik in eine dreidimensionale virtuelle Welt ist ein wesentlicher Bestandteil davon. Im Rahmen dieses Forschungsgebiet werden Algorithmen entwickelt mit dessen Hilfe Objekte nicht nur visuell begreifbar, sondern tatsächlich erfühlbar werden.

Im Rahmen dieser Arbeit werden verschiedene Ansätze zur Anwendung von Haptik auf virtuelle Objekte untersucht. Dazu gehören Verfahren zur Kollisionerkennung sowie die Berechnungsmethoden für rückwirkende Kräfte. Zusätzlich werden noch Algorithmen zur Deformation in Echtzeit untersucht. Darunter fallen elastische Deformationen beim Kontakt mit dem virtuellen Objekt und Algorithmen zur permanenten Verformung der Objekte.

Alle Ergebnisse wurden abschließend in ein Programm für die Visualisierung von dreidimensionalen Volumensdaten aus dem medizinischen Bereich (YaDiV ) integriert.

Beschreibungstext verbergen

Betreuer: Karl-Ingo Friese April 2009

Oktober 2009

|

|||

|

Master thesis

Daniel Pralle

Parallelisierte Berechnung zur Fluiddynamik auf der Cell B.E. Prozessorarchitektur

Beschreibungstext anzeigen

Im Forschungsgebiet der Virtual Reality Simulationen unterstützt durch den im Aufbau befindlichen VR-Raums, soll überprüft werden, welche Möglichkeiten sich durch den Cell Rechencluster eröffnen.

Die ausgeschriebene Arbeit hat hierbei zum Thema eine Fluiddynamik Simulation zu entwickeln, die hohe Rechenleistung von bis zu 6,4 Teraflops ausnutzen kann. Dabei sollen die Konzepte der Parallelisierung auf High Performance Cluster und die Spezialisierung des Cell Prozessors ausgenutzt werden, um eine interaktive Simulation zu ermöglichen. Im Forschungsgebiet der Virtual Reality Simulationen unterstützt durch den im Aufbau befindlichen VR-Raums, soll überprüft werden, welche Möglichkeiten sich durch den Cell Rechencluster eröffnen.

Die ausgeschriebene Arbeit hat hierbei zum Thema eine Fluiddynamik Simulation zu entwickeln, die hohe Rechenleistung von bis zu 6,4 Teraflops ausnutzen kann. Dabei sollen die Konzepte der Parallelisierung auf High Performance Cluster und die Spezialisierung des Cell Prozessors ausgenutzt werden, um eine interaktive Simulation zu ermöglichen.Januar 2009

Juli 2009

|

|||

|

Master thesis

Alexander Vais

Leibniz Universität Hannover

Untersuchungen zur Medialen Achse Transformation in der Ebene

Beschreibungstext anzeigen

Diese Arbeit befasst sich mit der Berechnung der Medialen Achse einer geschlossenen Spline-Kurve in der euklidischen Ebene. Obwohl diese Problemstellung bereits früh untersucht wurde, belegen neuere Arbeiten, dass noch Forschungsbedarf besteht. Ein Teilproblem ist die exakte Lokalisierung von Verzweigungspunkten, in denen sich mehrere mediale Äste treffen. Die Berechnung der Startpunkte, medialen Äste und Verzeigungspunkte der Medialen Achse kann in einer vereinheitlichenden Betrachtung auf das Problem der Nullstellensuche zurückgeführt werden. Als Verfahren zur Nullstellensuche werden unter anderem Homotopieverfahren, Prädiktor-Korrektor Techniken zur Pfadverfolgung sowie Spline-basierte Bisektionsverfahren vorgestellt.

Beschreibungstext verbergen

Betreuer: Hannes Thielhelm April 2009

|

|||

|

Master thesis

Maximilian Müller

Leibniz Universität Hannover

High-Quality Ray Casting Verfahren zur Visualisierung segmentierter medizinischer Voxeldaten

Beschreibungstext anzeigen

Betreuer: Karl-Ingo Friese Oktober 2008

April 2009

|

|||

| 2008 | |||

|

Master thesis

Daniela Lauer

A Generalized Architecture for Hybrid Tracking Including Inertial Sensor Technology

Beschreibungstext anzeigen

Tracking, als eines der wichtigsten Bestandteile der Realisierung von Augmented-Reality-Anwendungen, sorgt für die ortsspezifische Verknüpfung der Realität und der virtuellen Darstellung. Die anwendungsabhängigen Anforderungen an das Tracking können meist nicht durch bereits vorhandene Systeme oder Prototypen abgedeckt werden. Um positive Eigenschaften zu kombinieren und Mängel auszugleichen empfiehlt sich der Einsatz eines hybriden Trackingsystems, also die Fusion von Sensordaten. Um diese auf einfachem Wege zu ermöglichen werden im Rahmen dieser Arbeit Konzepte für flexible und sensorunabhängige Datenfusion aus anderen Fachgebieten auf die Anforderungen von Augmented-Reality-Anwendungen übertragen, um eine von der mathematischen Methode unabhängige Architektur und eine Kalman-Filter-Fusionsanwendung für den Augmented-Reality-Kontext zu gewinnen.

In die Struktur der vorgestellten Schnittstelle fließen außerdem Konzepte aus der Theorie der Datenfusion und verallgemeinerter Software im Tracking-Bereich ein. Zur Realisierung von Sensorvariabilität und einer schnellen Einbindung in Augmented-Reality-Anwendungen wurde eine Integration der Architektur in die Software OpenTracker bereits konzeptionell vorgesehen und im Rahmen der Kalman-Filter-Implementierung umgesetzt.

Die vorgestellte Software ermöglicht die Fusion von Positions-, Geschwindigkeits- beziehungweise Beschleunigungsdaten im Rahmen verschiedener Kalman-Filter-Architekturen als Knoten. Dieser kann flexibel in den OpenTracker-Flussgraphen eingebunden und so zu beliebigen Fusionsnetzwerken zusammengesetzt werden. Die Konfiguration erfolgt anhand einer XML-Spezifikation, die auch die Integration eigener Anwendungen und die Möglichkeit des verteilten Trackings einbezieht.

Anhand synthetischer Daten wird die Verbesserung durch die Fusion der Messdaten verschiedener Quellen mit der Umsetzung demonstriert und der Erfolg des Einsatzes von Inertialsensoren in Kombination mit markerbasierten beziehungsweise markerlosem Tracking gezeigt. Außerdem werden die verschiedenen Systemmodelle für die Kalman-Filterung erläutert, anhand derer eine anwendungsabhängige Konfiguration der Datenfusion möglich ist.

Die vorgelegte Arbeit enthält außerdem eine umfangreiche theoretische Betrachtung der Kalman-Filterung, insbesondere auch eine Einführung in die verschiedenen Möglichkeiten der Sensordatenfusion mit dem Filter. Weiterhin werden andere mathematische Verfahren zur Fusion von Daten für das Single-Target-Tracking vorgestellt.

Für eine zukünftige Erweiterung der Implementation eröffnet das vorgeschlagene Konzept eine Vielzahl zusätzlicher Umsetzungsmöglichkeiten. Die vorgestellte Architektur bietet eine gute Grundlage für die Umsetzung beliebiger Sensordatenfusionssysteme im Augmented-Reality-Bereich. Die implementierte Kalman-Filter-Fusions-Anwendung ermöglicht eine Verbesserung von Trackingverfahren durch Sensordatenfusion und kann als Basis für zahlreiche Erweiterungen im Hinblick auf die unterschiedlichsten Anwendungen dienen.

Beschreibungstext verbergen

Betreuer: allerkam@welfenlab.de November 2007

Juli 2008

|

|||

|

Master thesis

Coester Julia

Entwicklung haptischer Modellierkonzepte für die Medialen-Achsen-Rücktransformation

Beschreibungstext anzeigen

Ziel dieser Masterarbeit ist es, den am Lehrstuhl entwickelten Medial Modeller, der auf dem Konzept der Medialen-Achse aufgebaut ist, um Haptik und einen dynamischen, intuitiven Verformungsalgorithmus zu erweitern. Der Verformungsalgorithmus setzt an der Radiusfunktion an und durchläuft mehrere Schritte um eine Verformung der Radiusfunktion zu erreichen, unter anderem auch einen B-Spline-Deformierungsalgorithmus, der das B-Spline so verformt, dass ein verschobener Oberflächenpunkt genau an der Stelle liegt, wohin er geschoben wurde. Der Verformungsalgorithmus nutzt die Vorteile der Haptik aus, indem über das Haptikgerät die Verformung gesteuert wird. Dadurch lässt sich die Verformungsfunktion sich sehr intuitiv steuern.

Des weiteren wird in dieser Masterarbeit näher auf Konzepte zur Einbindung von Haptik in ein Programm eingegangen. Allgemein wird die Haptik näher beleuchtet und auch der Medial Modeller genauer beschrieben.

Ziel dieser Masterarbeit ist es, den am Lehrstuhl entwickelten Medial Modeller, der auf dem Konzept der Medialen-Achse aufgebaut ist, um Haptik und einen dynamischen, intuitiven Verformungsalgorithmus zu erweitern. Der Verformungsalgorithmus setzt an der Radiusfunktion an und durchläuft mehrere Schritte um eine Verformung der Radiusfunktion zu erreichen, unter anderem auch einen B-Spline-Deformierungsalgorithmus, der das B-Spline so verformt, dass ein verschobener Oberflächenpunkt genau an der Stelle liegt, wohin er geschoben wurde. Der Verformungsalgorithmus nutzt die Vorteile der Haptik aus, indem über das Haptikgerät die Verformung gesteuert wird. Dadurch lässt sich die Verformungsfunktion sich sehr intuitiv steuern.

Des weiteren wird in dieser Masterarbeit näher auf Konzepte zur Einbindung von Haptik in ein Programm eingegangen. Allgemein wird die Haptik näher beleuchtet und auch der Medial Modeller genauer beschrieben.

November 2007

Juni 2008

|

|||

|

Master thesis

Chavdar Papazov

Morphing zwischen triangulierten Nicht-Mannigfaltigkeiten unter Berücksichtigung topologischer Änderungen

Beschreibungstext anzeigen

In der Arbeit aus dem Bereich Bio-Imaging wurde der Prozess der morphologischen Veränderungen bei der Entwicklung eines Samenkorns untersucht. September 2007

Februar 2008

|

|||

| 2007 | |||

|

Master thesis

Richard Guercke

Leibniz Universität Hannover

Boundary Extraction from Voxel Data Using Contour Lines

Beschreibungstext anzeigen

In this thesis, an algorithm is introduced that extracts a boundary surface from a voxel data set representation of a shape. To achieve this objective, a connectivity graph is constructed from boundary polygons of the object in (usually orthogonal) 2D slices. This graph is used to find facets of the object's boundary surface. In this thesis, an algorithm is introduced that extracts a boundary surface from a voxel data set representation of a shape. To achieve this objective, a connectivity graph is constructed from boundary polygons of the object in (usually orthogonal) 2D slices. This graph is used to find facets of the object's boundary surface.At given sampling intervals, the resulting triangulated surfaces bear a considerably closer resemblance to the original voxel data object than the result of the (modified) Marching Cubes algorithm. This is, however, only achieved at the cost of an increase in computation time and memory usage. At the closest sampling interval, the algorithm returns a closed surface without self-intersections. The connectivity graph can also be used for the restriction of surface patches to be displayed according to visibility or as a basis for physical computations like FEM analysis. Project: YaDiV Betreuer: Karl-Ingo Friese Juni 2007

November 2007

|

|||

|

Master thesis

Michael Hanel

Leibniz Universität Hannover

Untersuchung und Implementation verschiedener Kollisionserkennungsalgorithmen für deformierbare Körper

Beschreibungstext anzeigen

Due to the rapid development in the graphics card sector, Virtual Reality (VR) Applications are getting a broader application range. In general VR-Applications try to map the real world to a virtual counterpart preserving the physical realism. Concerning the latter aspect, this is a very challenging task due to the requirements of user interaction. A crucial component of the VR-System is the collision detection. Realism in virtual environments demands avoidance of invalid states like intersection of objects. In the context of the HAPTEX-Project (hapti interaction with virtual textiles) methods detecting the aforementioned states are presented. Moreover, a scheme for resolving collisions and technical solutions related to the integration within the HAPTEX VR-System architecture are shown. Februar 2007

August 2007

|

|||

|

Master thesis

Sebastian Preuin

Leibniz Universität Hannover

Ein lernendes System zur taktilen Darstellung von Textilien

Beschreibungstext anzeigen

The satisfying simulation of surfaces of real fabrics is notwithstanding intensive efforts an unsolved problem. Within the HAPTEX project some procedures were developed, which used height profiles for calculating the output of simulations done by a tactile display. Methods were examined in this master thesis, how a simulation can be calculated without a height profile. The values of different parameters, which are determined by test persons, are compared with each other. The results of the test series show that some subjects selected similar attitudes of parameter and thereby created different concentration areas in the range of parameter for each used fabric. The results are ambiguous, but are promising that the use of memory-complex height profiles can be decrepit in the future.

Beschreibungstext verbergen

Betreuer: allerkam@welfenlab.de August 2007

|

|||

|

Master thesis

Cem Dogan

Leibniz Universität Hannover

Mediale-Achsen-Rücktransformation in Riemannschen Mannigfaltigkeiten

Beschreibungstext anzeigen

The Medial Axis is the set of centers of all maximally inscribed spheres. This geometric concept is used for object representation and, together with the Medial Axis Inverse Transform (MAIT), for modeling of solids by editing their medial surface and a radius function.

Extending the three-dimensional Euclidean to the Riemannian situation allows to treat physical and technical problems that can be modeled with an adapted metric.

The Geodesic Medial Modeler (GMM) is a tool to design the Medial Axis as a tensor spline surface and to deform the Euclidean space locally. It performs the associated MAIT calculations in real time and visualizes the resulting envelope in the three-dimensional parameter space.

Beschreibungstext verbergen

Betreuer: few@welfenlab.de Januar 2005

Mai 2007

|

|||

| 2006 | |||

|

Master thesis

Maxim Marchenko

Leibniz Universität Hannover

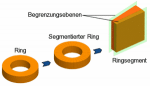

Dynamische 3D-Visualisierung eines Radial-Axial-Ringwalzprozesses

Beschreibungstext anzeigen

Im Rahmen dieser Arbeit wurde eine 3D-Visualisierungssoftware entwickelt, die aufbauend auf einer am Institut für Umformtechnik und Umformmaschinen (IfUM) der Leibniz Universität Hannover entwickelten Simualtion, einen Radial-Axial-Ringwalzprozess dynamisch darstellt. Ziel ist es hierbei, den Ingenieur arbeitsbegleitend bei der Evaluation und Analyse während der Spezifikation einer Ringwalzstrategie zu unterstützen. Die Hauptanforderung für die Simulation besteht daher in der schnellen Vorhersage des Werkstofffluss und der Ringgeometrie zu jedem Zeitpunkt des Walzprozesses. Betreuer: blanke@welfenlab.de Dezember 2006

|

|||

|

Master thesis

Karin Matzke

Leibniz Universität Hannover

Ein System zur taktilen Simulation ebener Oberflächen

Beschreibungstext anzeigen

In der modernen Computertechnik spielt die Bedeutung der so genannten Virtuellen Realität eine immer wichtigere Rolle. Dabei ist es das Ziel, eine künstliche oder reale "Welt" mit dem Computer zu simulieren und durch entsprechende Ausgabegeräte für alle Sinne wahrnehmbar zu machen. Neben Geräten für Seh- und Hörsinn ist dabei jedoch ein Sinn noch wenig bedacht: der Tastsinn. Dabei ist die Menge an Informationen, die wir von unserer Umwelt und der Interaktion mit der Umwelt über den Tastsinn wahrnehmen, so groß wie von keinem anderen Sinn. Daher liegt es nahe, auch für diesen Sinneskanal entsprechende Hard- und Software zu entwickeln. Betreuer: allerkam@welfenlab.de November 2006

|

|||

|

Master thesis

Marc Herrlich

Leibniz Universität Hannover

Untersuchungen zur Eignung von 3D-Spieleengines für die wissenschaftliche Visualisierung anhand der CryENGINE

Beschreibungstext anzeigen

Computerspiele sind in heutiger Zeit aus dem Alltag vieler Menschen nicht mehr wegzudenken. Darüber hinaus erreichte die Technologie moderner Spiele im Laufe der letzten Jahre einen Standard, der diese auch für Anwendungen fernab des Unterhaltungssektors interessant macht.

Die Visualisierung wissenschaftlicher Daten ist ein bedeutendes Anwendungsgebiet der graphischen Datenverarbeitung. Insbesondere die interaktive dreidimensionale Darstellung virtueller oder realer Umgebungen stellt ein wichtiges Hilfsmittel dar.

In dieser Arbeit wird anhand der in dem Computerspiel Farcry eingesetzten CryEngine untersucht, welche Möglichkeiten moderne Spieleengines für die wissenschaftliche Arbeit bieten. Als Anwendungsbeispiel soll mit Hilfe der CryEngine eine auf GIS-Daten basierende dreidimensionale Landschaftsdarstellung umgesetzt werden. Dazu wird in der vorliegenden Arbeit ein Konverter entwickelt, um automatisiert aus vorhandenen GIS-Daten einen entsprechenden Farcry-Level zu erzeugen.

Computerspiele sind in heutiger Zeit aus dem Alltag vieler Menschen nicht mehr wegzudenken. Darüber hinaus erreichte die Technologie moderner Spiele im Laufe der letzten Jahre einen Standard, der diese auch für Anwendungen fernab des Unterhaltungssektors interessant macht.

Die Visualisierung wissenschaftlicher Daten ist ein bedeutendes Anwendungsgebiet der graphischen Datenverarbeitung. Insbesondere die interaktive dreidimensionale Darstellung virtueller oder realer Umgebungen stellt ein wichtiges Hilfsmittel dar.

In dieser Arbeit wird anhand der in dem Computerspiel Farcry eingesetzten CryEngine untersucht, welche Möglichkeiten moderne Spieleengines für die wissenschaftliche Arbeit bieten. Als Anwendungsbeispiel soll mit Hilfe der CryEngine eine auf GIS-Daten basierende dreidimensionale Landschaftsdarstellung umgesetzt werden. Dazu wird in der vorliegenden Arbeit ein Konverter entwickelt, um automatisiert aus vorhandenen GIS-Daten einen entsprechenden Farcry-Level zu erzeugen.Betreuer: Karl-Ingo Friese März 2006

|

|||

|

Master thesis

Tjard Köbberling

Leibniz Universität Hannover

Verschiedene Methoden zur Generierung virtueller taktiler Oberflächenstrukturen

Beschreibungstext anzeigen

Virtuelle Realität ist die Darstellung der Wirklichkeit und ihrer physikalischen Eigenschaften in einer in Echtzeit computergenerierten virtuellen Umgebung. Neben der optischen und akustischen Wahrnehmung kann auch die taktile Wahrnehmung in der virtuellen Umgebung möglich gemacht werden. Unter taktiler Wahrnehmung wird das Erkennen von Druck, Berührung und Vibrationen auf der Haut verstanden. Es wurden verschiedene, bereits in vorherigen Arbeiten beschriebene Methoden zur Generierung virtueller taktiler Oberflächenstrukturen implementiert und miteinander verglichen. Als Vorlage dienten dabei Textilien, die in der virtuellen Umgebung möglichst realistisch dargestellt werden sollten.

Beschreibungstext verbergen

Betreuer: allerkam@welfenlab.de Januar 2006

|

Bildgebende Verfahren haben insbesondere in der medizinischen Anwendung eine große Verbreitung erfahren. So sind z.B. Computertomographie oder Magnet-Resonanz-Tomographie aus dem klinsichen Alltag nicht mehr wegzudenken. Um die gewonnen 3D-Daten auch 3-dimensional zu visualiseren, können unterschiedliche Methoden des Direct-Volume-Rendering verwendet werden. Die Algorithmen unterscheiden sich vor allem in Laufzeit und Bildqualität. Ein vergleichender Überblick über die gängigen Verfahren wird z.B. in der Diplomarbeit von Dominik Sarnow gegeben.

Bildgebende Verfahren haben insbesondere in der medizinischen Anwendung eine große Verbreitung erfahren. So sind z.B. Computertomographie oder Magnet-Resonanz-Tomographie aus dem klinsichen Alltag nicht mehr wegzudenken. Um die gewonnen 3D-Daten auch 3-dimensional zu visualiseren, können unterschiedliche Methoden des Direct-Volume-Rendering verwendet werden. Die Algorithmen unterscheiden sich vor allem in Laufzeit und Bildqualität. Ein vergleichender Überblick über die gängigen Verfahren wird z.B. in der Diplomarbeit von Dominik Sarnow gegeben.